- batch

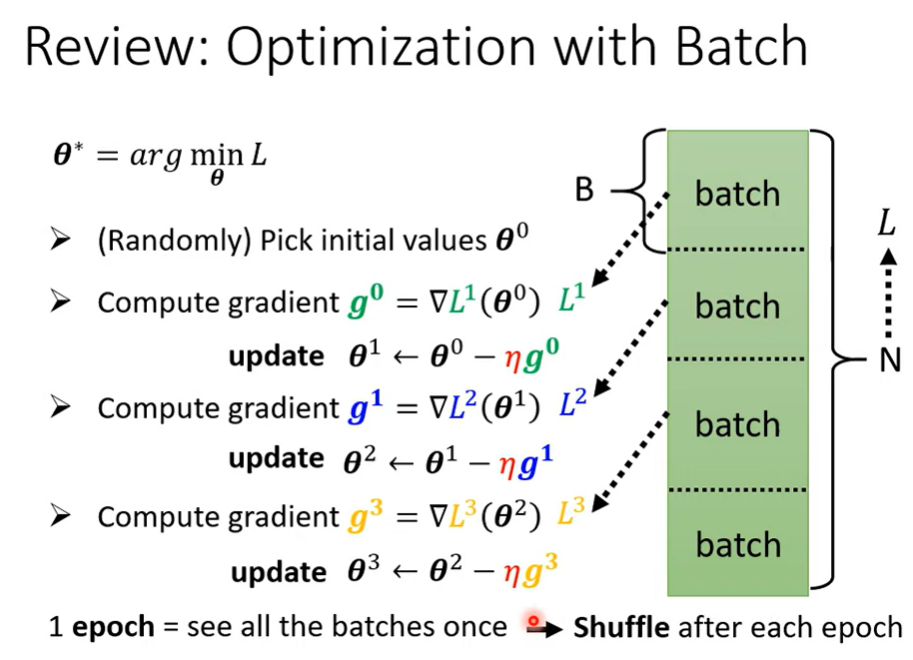

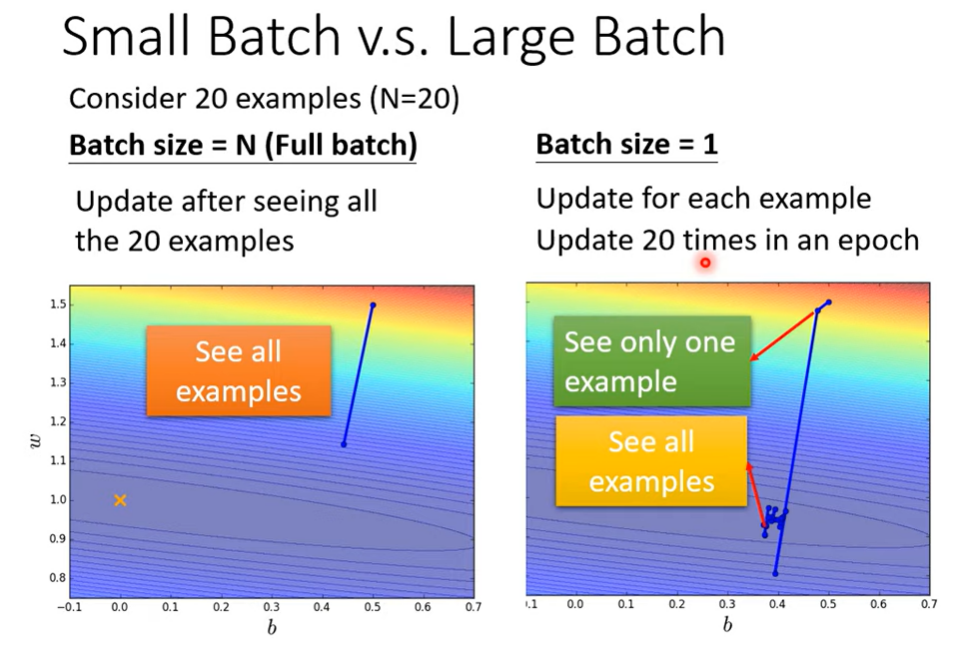

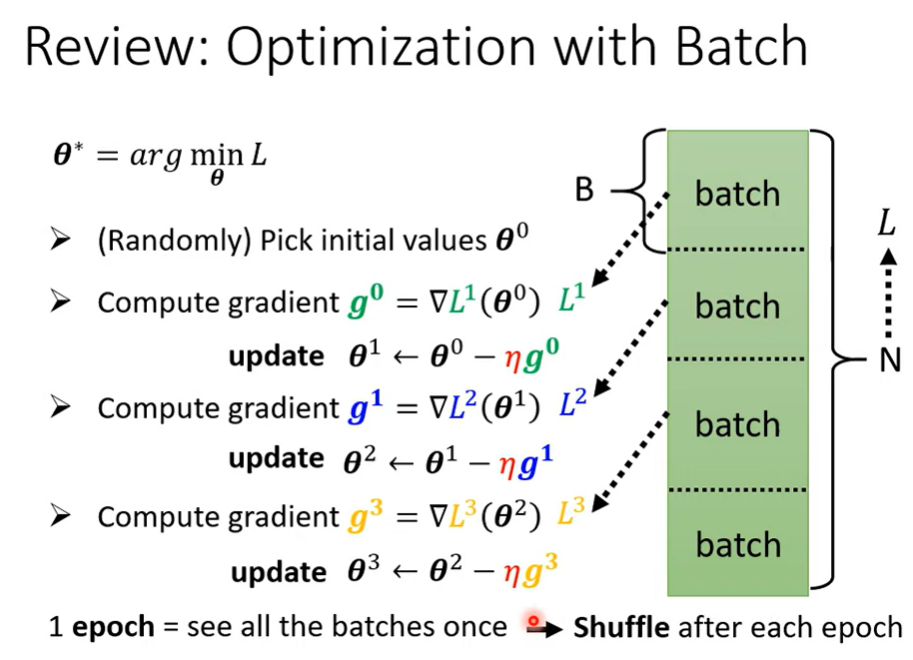

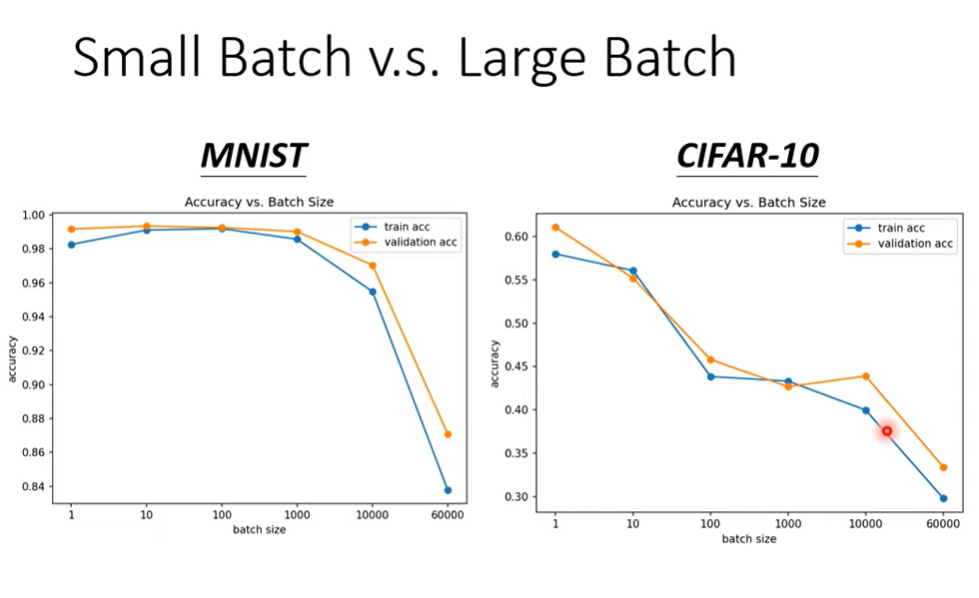

在实际训练过程中,会将数据集分为多个batch,每个batch训练完成后的g都会对参数进行更新,当一个周期所有batch数据训练完成后,在下一个周期开始前,会将数据打乱重新分割batch再进行计算。(这里涉及到批量梯度下降)

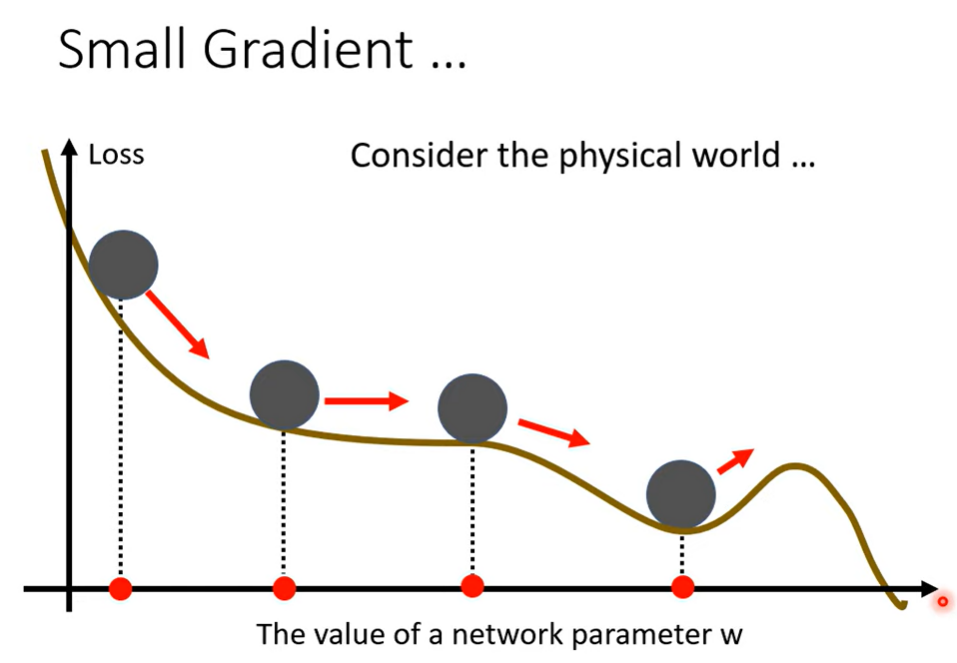

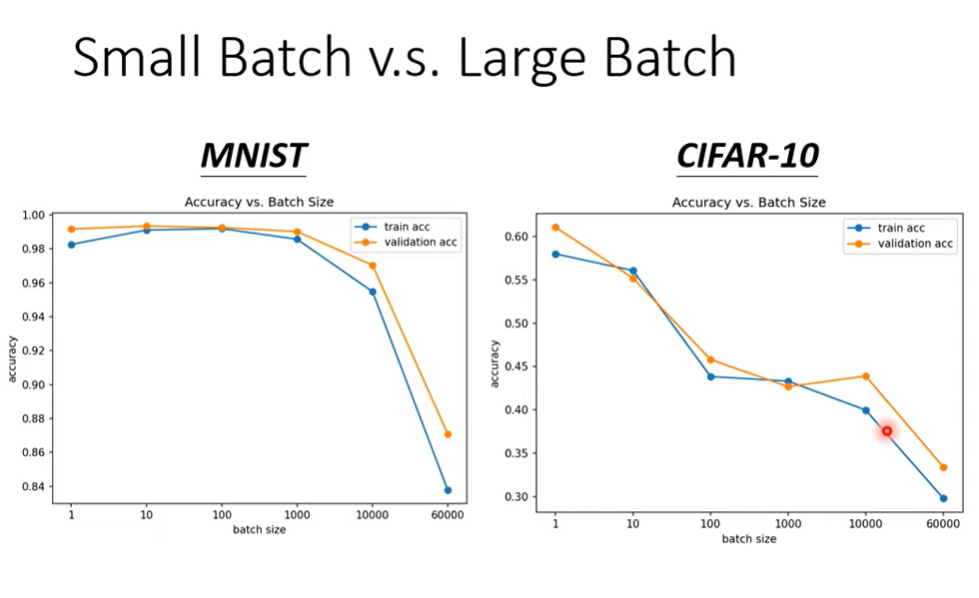

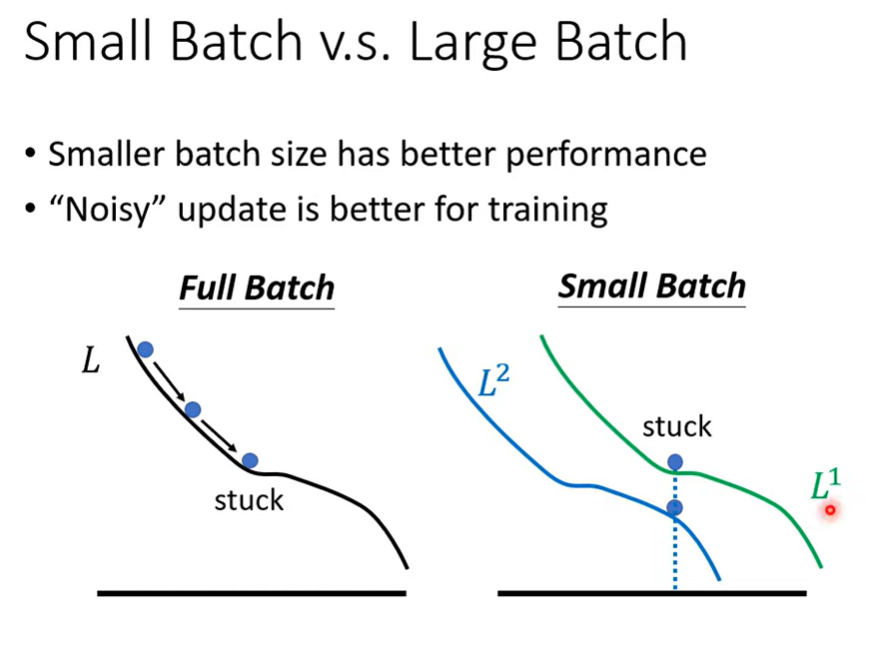

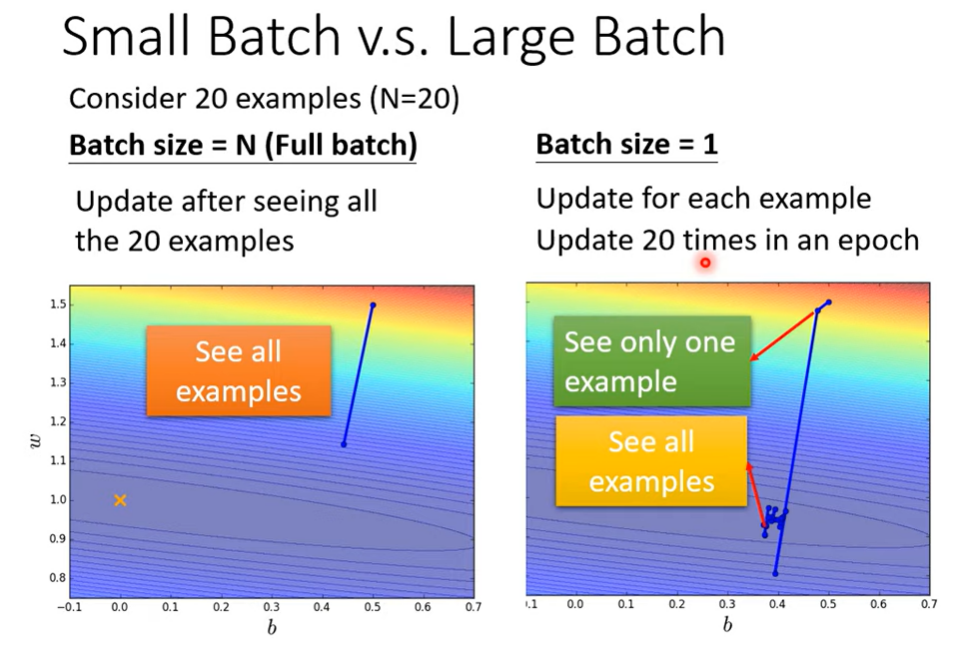

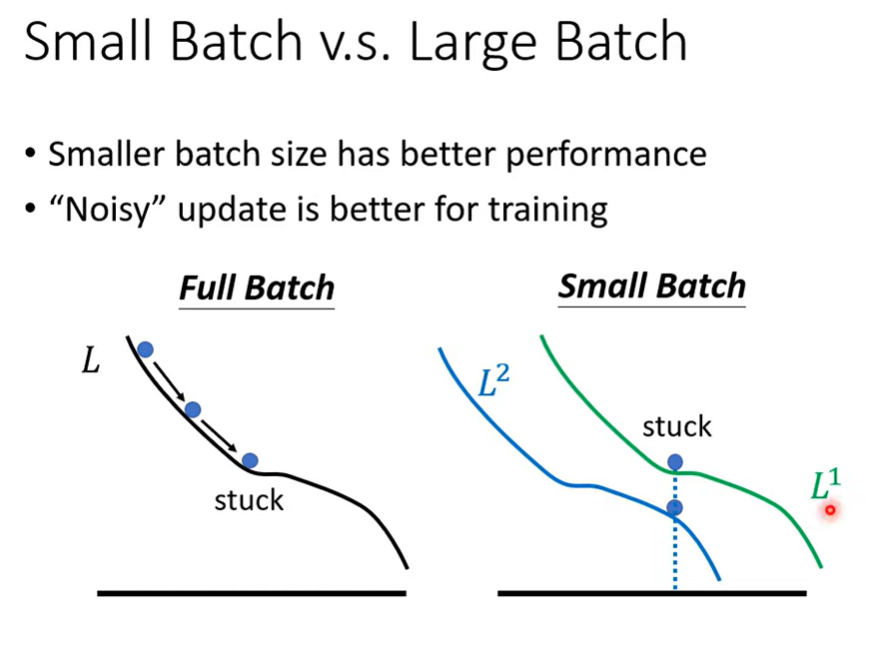

当使用更小的batch时,能使用数据集进行更多次的参数更新,但是每一次的识别更为不准确一些,如果只是用一个大的batch,参数更新的方向更准确,但是得到的最终参数可能不如小batch好,但batch越小越好吗?

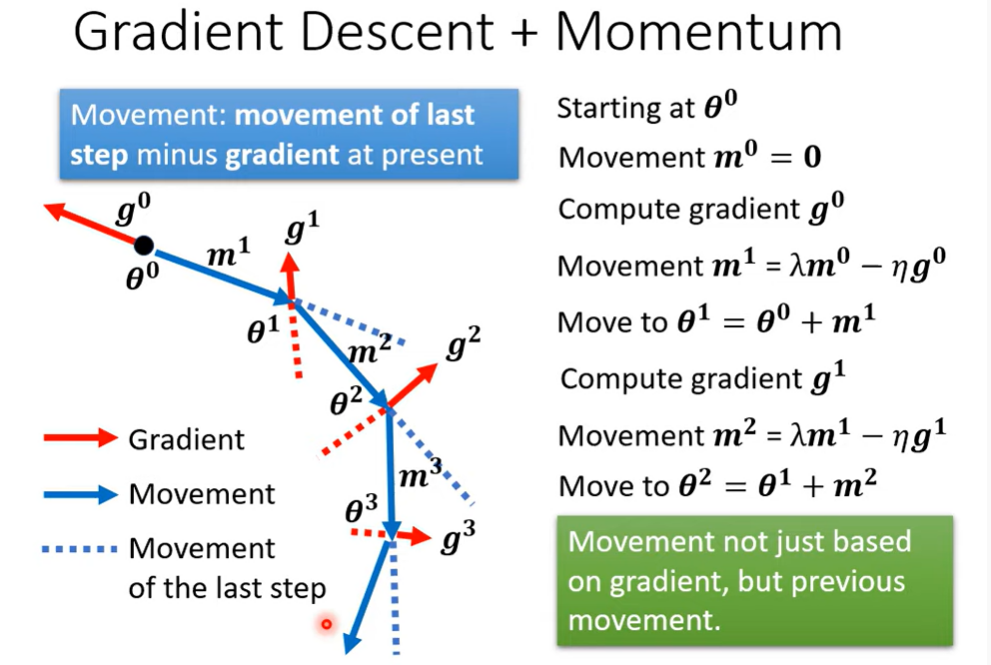

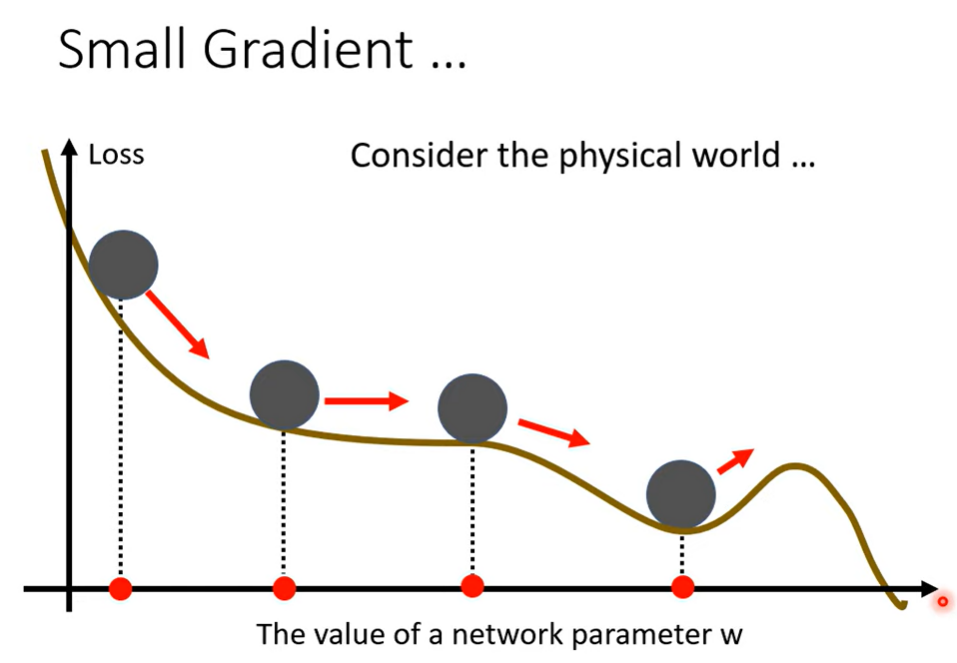

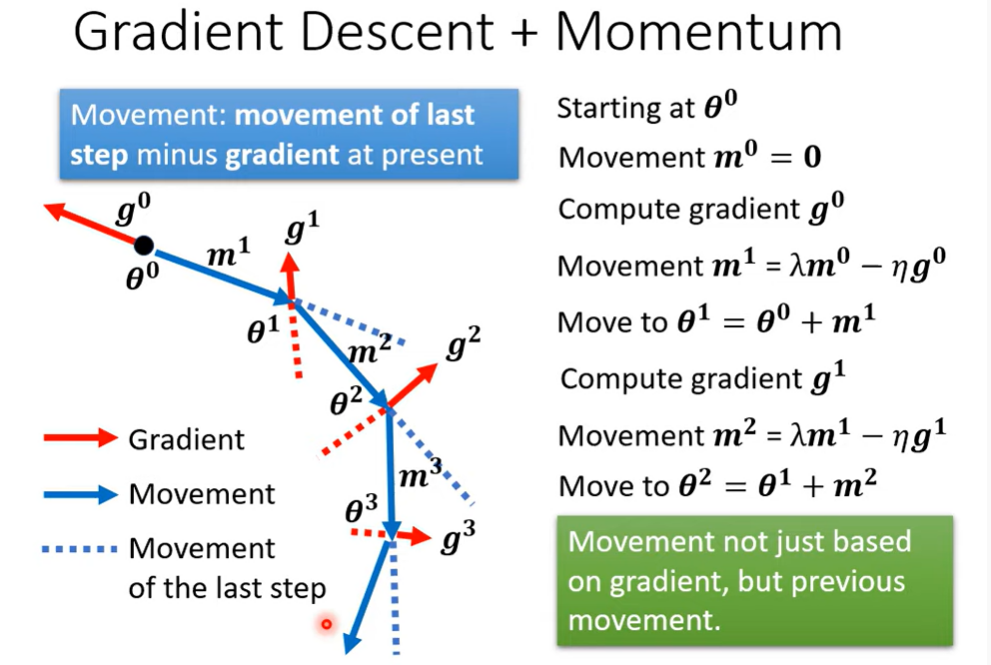

2.momentum

山高路远,风情雅致

在实际训练过程中,会将数据集分为多个batch,每个batch训练完成后的g都会对参数进行更新,当一个周期所有batch数据训练完成后,在下一个周期开始前,会将数据打乱重新分割batch再进行计算。(这里涉及到批量梯度下降)

当使用更小的batch时,能使用数据集进行更多次的参数更新,但是每一次的识别更为不准确一些,如果只是用一个大的batch,参数更新的方向更准确,但是得到的最终参数可能不如小batch好,但batch越小越好吗?

2.momentum